-

[PoseTracking] AlphaPose 환경 설정Deep Learning 공부자료/Alphapose 2020. 4. 27. 16:24

가상환경 생성

파이썬 버전을 3.6으로 맞춰서 가상환경을 생성 해 준다.

conda create -n {가상환경 이름} python=3.6 -y가상 환경을 실행 시킨다.

conda activate {가상환경 이름}Pytorch 설치하기

conda install pytorch==1.1.0 torchvision==0.3.0Alphapose clone하기

git에서 clone해온다.

git clone https://github.com/MVIG-SJTU/AlphPose.gitAlphapose 설치하기

Alphapose 디렉토리로 이동하고, 아래와 같은 과정을 따라서 install 해준다.

(마지막 줄이 진짜 엄청 오래 걸린다.)

export PATH=/usr/local/cuda/bin/:$PATH export LD_LIBRARY_PATH=/usr/local/cuda/lib64/:$LD_LIBRARY_PATH python -m pip install cython sudo apt-get install libyaml-dev python setup.py build developObject Detection model 다운 받기

YOLO version3을 다운 받아서, detector/yolo/data 에 넣어준다.

(YOLO version4가 나온거 같던뎅..?!)

Object Tracing model 다운 받기

JDE-1088X609-uncertaint를 다운 받으라는데, 정확히 어떤건지는 잘 모르곘다.

Pose tracking을 위해서 당연히 object tracking 모델이 필요하겠지- 정도로 이해하고 넘어가려 한다.

다운 받아서, detector/tracker/data 에 넣어준다.

참고로 yolo 디렉토리와 tracker 디렉토리에는 data 디렉토리가 없다.

따라서 data 디렉토리를 만들어서 넣어주는 거 같다.

AlphaPose model 다운 받기

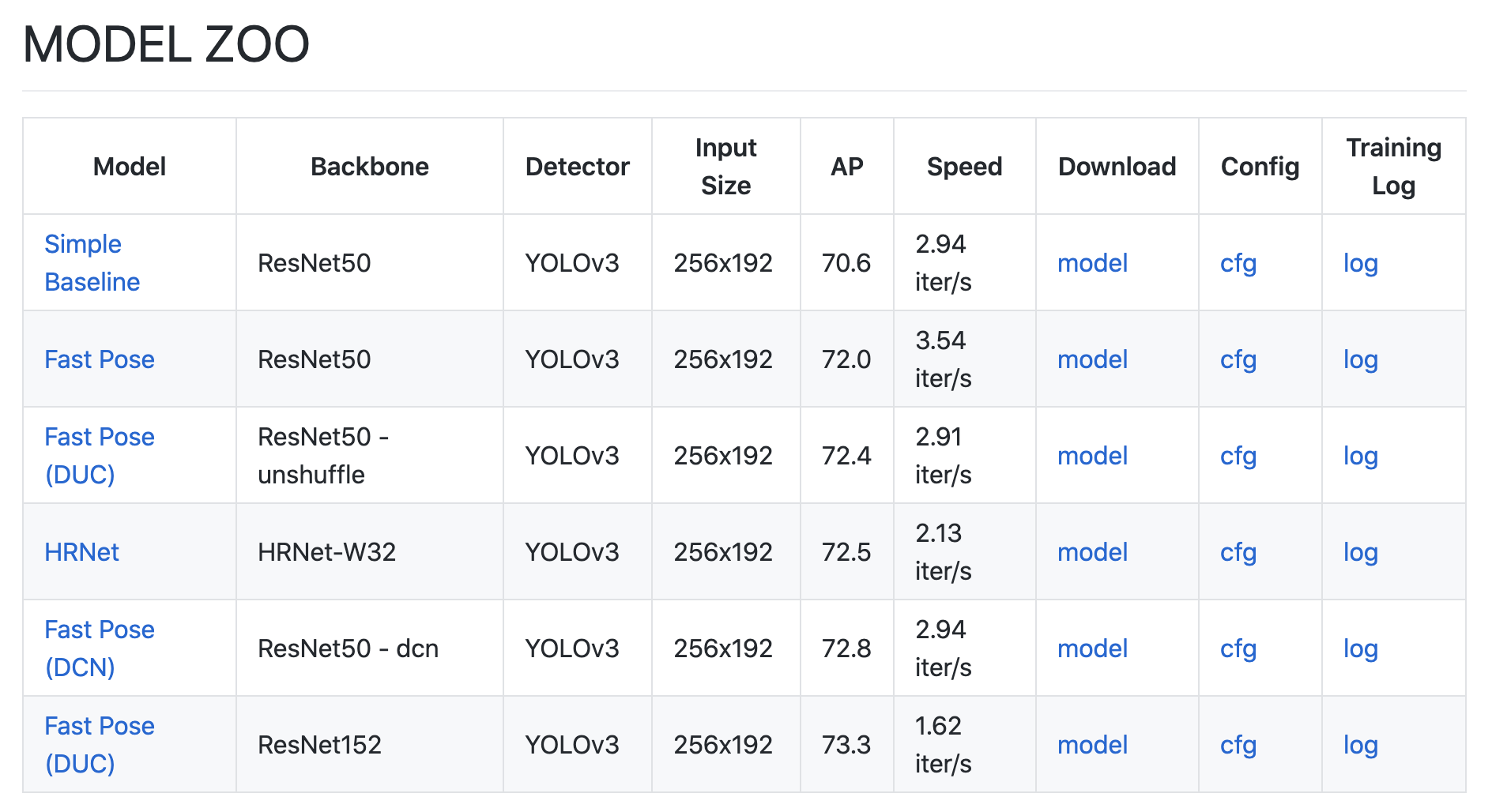

이제 실제로 내가 사용하고 싶은 모델인 AlphaPose의 모델들을 다운 받을 것이다.

아래는 AlphaPose가 제공하는 6가지 모델들이다. 어떤 것을 실제로 사용하게 될지는 프로젝트를 진행하면서,

결정해야할 듯 해서, 일단 여섯가지를 모두 다운 받았다.

다운 받아서, pretrained_models 에 넣어준다. (pretrained_models는 기존에 만들어져 있으므로 따로 만들 필요 없다.)

Dataset 준비하기

깃허브 설명에는 옵션이라고 표시되어 있긴 한데, 내가 제대로 설치했는지 확인하려면, 어차피 데이터가 필요하니까..!

MSCOCO 2017 training 데이터와 validation 데이터를 다운 받는다

(training 데이터 받는데 또 진짜 오래 걸린다....)